2025年11月8日,国际人工智能领域顶级会议The 40th Annual AAAI Conference on Artificial Intelligence (AAAI 2026)论文录用结果揭晓,山东大学软件学院孟雷教授负责的MMRC实验室在图像、视频因果表示的成果共计两篇论文被该会议录用。会议计划于2026年1月20日至1月27日在新加坡举行。AAAI会议是人工智能领域的重要学术会议,被中国计算机学会评定为A类学术会议。这次会议共收到23,680篇有效投稿,接收4167篇,录用率约17.6%。

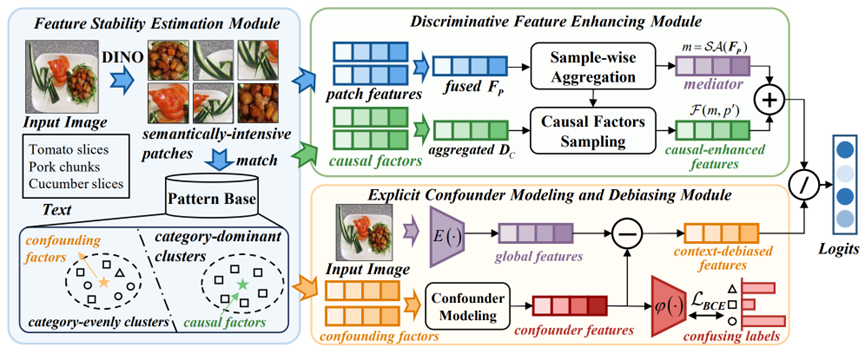

论文名称:Explicit Modeling of Causal Factors and Confounders for Image Classification

论文作者:吴畏(山东大学),孟雷*(山东大学),齐壮(山东大学),李子璇(山东大学),张亚冲(山东大学),闫晓硕(山东大学),孟祥旭(山东大学)

论文简介:因果推断正日益成为视觉表征学习中识别关键语义因素、剔除虚假关联的重要技术路径。然而,大多数现有方法仍依赖潜在的、数据驱动式的混淆因素建模,往往将偏差简单归因于背景信息,而忽略了复杂场景中普遍存在的目标级语义混淆。这类忽视导致模型在因果因素与混淆语义之间的解耦粒度不足,限制了其在高复杂度场景下的鲁棒性和泛化能力。为应对这一问题,我们提出了一种对因果因素与混淆因素进行显式语义建模的新框架Explicit Modeling Causal Model(EMCM)。在该框架中,特征稳定性估计模块利用聚类模式显式刻画视觉语义与类别标签之间的关系,从类别分布中区分出稳定的因果因素与不稳定的混淆因素,进而获得类别特定的因果语义和易混类别对应的混淆模式。随后,判别特征增强模块通过前门干预机制,将因果因素有效注入融合后的 patch 特征中,从而构建更具稳定性和判别力的语义表示。与此同时,显式混淆因素建模与去偏模块在标签约束下细化样本级混淆因素,并结合 TDE 建模生成上下文去偏后的特征表示,实现对语义噪声与上下文虚假关联的系统性抑制。该方法从两种互补的因果视角构建统一的语义表征,在复杂场景中显著提升模型的泛化性与对歧义语义的鲁棒性。大量实验结果表明,EMCM 能够有效分离因果语义与混淆语义,在两个公开数据集上 top-1 准确率相比现有因果去偏方法提高 2%–5%。

图1:EMCM 的整体架构

Paper链接:

https://github.com/ww01911/EMCM/blob/main/aaai_21031(1).pdf

Code链接:

https://github.com/ww01911/EMCM

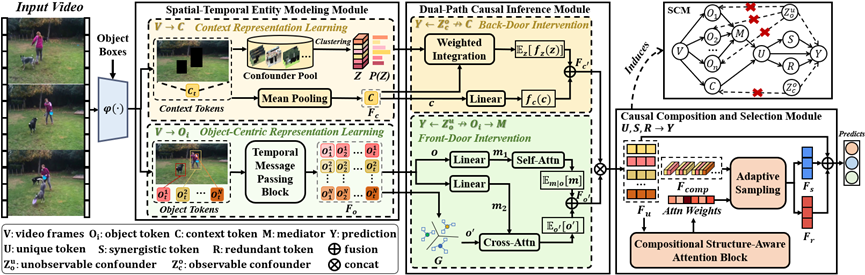

论文名称:Introducing Decomposed Causality With Spatiotemporal Object-Centric Representation For Video Classification

论文作者:张亚冲(山东大学),孟雷∗(山东大学), 胥硕(山东大学), 齐壮(山东大学),吴畏(山东大学),武蕾(山东大学),孟祥旭(山东大学)

论文简介:视频分类需要对对象及其交互进行事件级表示,而现有方法通常依赖数据驱动的方式,从整帧或对象中心的视觉区域中学习特征,因此往往忽略了对象间的时空交互。为此,本文提出了一种协同、独特与冗余因果表示分解学习(SurdCRL)模型,该模型引入 SURD 因果理论,用于建模对象动态及其帧内与跨帧交互的时空特征。具体而言,SurdCRL 通过三个模块对对象中心的时空动态进行建模:时空实体建模模块将帧解耦为对象与上下文实体,并利用时序消息传递捕捉对象状态随时间的变化,生成基本因果变量;双路径因果推理模块通过前门和后门干预缓解因果变量间的混淆因素,使后续因果成分能够反映其内在效应;因果组合与选择模块利用结构感知组合注意力,将因果变量及其高阶交互映射为协同、独特和冗余三类因果成分。为验证 SurdCRL 的有效性,我们在两个基准数据集上开展了大量实验,包括性能对比、消融实验、深度分析及案例研究。结果表明,SurdCRL 通过融入因果理论,能够有效建模目标表征。本文的主要贡献如下:(1) 提出一种基于 SURD 理论的 SurdCRL 因果模型,将因果关系分解为协同、独特和冗余成分。据我们所知,这是首个在视频分类任务中对目标中心表征进行因果建模的模型。(2) 通过因果推理减轻了因果变量间混杂因素带来的偏差,能够更好地建模高阶交互,使每个因果成分都能为分类任务发挥真实效用。(3) 实验结果验证,SurdCRL 通过因果分解优化了结构因果模型,让模型能够聚焦与事件相关的目标中心交互,实现精准的视频理解。

图2: SurdCRL框架图

Paper链接:

https://github.com/iubcojay/SurdCRL/blob/main/SurdCRL.pdf

Code链接:

https://github.com/iubcojay/SurdCRL